Data for History 2020: Modelling Time, Space, Agents

Call for papers

28-29 May 2020, Berlin (Germany)

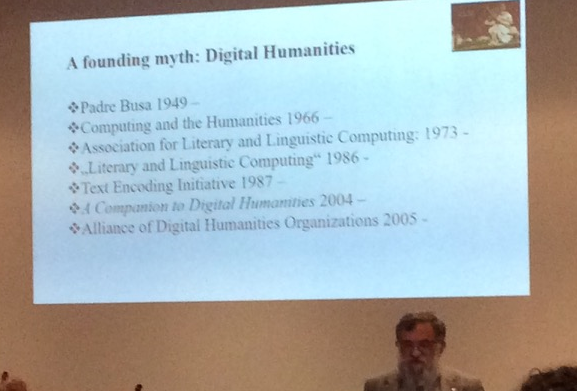

Participants at the first Data for History workshop – Lyon, 24. November 2017.

(Thomas Hänsli, CC BY-NC-ND 4.0)

The Data for History consortium invites proposals for its first annual conference, which will be held May 28-29, 2020 at the Humboldt University of Berlin.

The effects of the growing integration of digital tools and methods in historical research make the issues of interoperability of data produced in different projects and domains (archives, museums, etc.), and their reuse in the context of open science and FAIR principles (data should be findable, accessible, interoperable and reusable) ever more pressing.

In fact, we are at a turning point in historical research: The change from a primarily analogue based to a primarily digital based working context requires a major reconsideration of the very foundations of our field. Historians have to consciously think through how this change affects their practices and determine the means to best form this new, digital working environment to facilitate the ends of historical research.

This question becomes particularly clear in the context of datafication, the conversion of analogue information into digital data. In this process, fundamental decisions are taken whose outcomes will determine not only the fidelity of the representation of the primary sources but the reusability of that data into the future. Data modelling decisions taken today will deeply shape and affect the kind of research that will or will not be feasible tomorrow. The challenge is, thus, to make modelling choices in such a way that the highest possible degree of data reusability and sustainability can be guaranteed, while respecting the particular source modelled as well as the specific nature of historical data, such as ambiguity, uncertainty, incompleteness, and change over time.

This conference will explore the process of data modelling and its implications for future research practices, focussing on three fundamental categories of historical research: time, space and agents.

In this context, time can be understood as astronomical time, as socially constructed or measured, but also as expressed in the form of temporal relations, events, durations and rhythms, synchronous or asynchronous, etc. The category of space may include concrete physical places, territories and their borders as well as spatial relations and arrangements but also conceptual or imaginary places and mental maps. The concept of agents, meanwhile, may refer to persons, but also groups of persons like families, officeholders or informal communities, as well as institutions and other entities that produce changes over time by taking action.

We are looking for different approaches on how to model these historical fundamentals. We will analyse in depth the use of more or less established models and standards like CIDOC CRM and EDTF, but also want to explore new models, ideas and methods. Moreover, it will be essential to include critical accounts from concrete projects, focussing on the possibilities and limitations of these different methods and approaches.

Overall, the conference aims to build a better insight into current ideas and practices in modelling time, space and agents as historical data and to assess the implications of these choices on the process of historical research and analysis.

We invite historians, computer scientists, data and information specialists, as well as research software engineers, designers and cultural heritage experts working on data modelling for historical sources to present their work at the conference. We welcome presentations regarding theoretical considerations concerning these or related questions, introducing methodologies or presenting case studies on the application of those approaches to concrete research projects and sharing their experiences and challenges.

The conference will be followed by the annual meeting of the Data for History consortium (http://dataforhistory.org/), an international community aiming to establish a common method for modelling, curating and managing data in historical research.

The publication of selected papers is intended.

Submissions

Submissions may include:

- Papers: 15-minute presentations followed by discussion (abstract 750-1000 words)

- Posters: Call with selection. Posters already submitted in other conferences (please mention it in the summary) are admitted (abstract 250-500 words)

All proposals should include relevant citations to sources in the appropriate literature. Citations are not to be included in the word count.

Submit a Proposal: https://d4h2020.sciencesconf.org/

Bursaries

The conference organiser will offer a limited number of bursaries for PhD students and early-career scholars presenting at the conference.

Scientific committee

- Francesco Beretta (CNRS/Université de Lyon)

- George Bruseker (Takin.solutions)

- Arianna Ciula (King’s College London)

- Sebastiaan Derks (Huygens Institute for the History of the Netherlands)

- Antske Fokkens (VU Amsterdam)

- Charles van den Heuvel (University of Amsterdam)

- Solenn Huitric (Université de Lyon)

- Georg Vogeler (Universität Graz)

- Torsten Hiltmann (Humboldt-Universität zu Berlin)

Important dates

Deadline for submissions: 1 March 2020

Notification of acceptance: 31 March

Camera-ready for the summary: 1 May

Conference: 28/29 May

Conference Venue

Humboldt University of Berlin

Banquet Hall

Luisenstraße 56

10115 Berlin

Organisation

Torsten Hiltmann

Professor of Digital History

Institut für Geschichtswissenschaften

Humboldt University of Berlin

Unter den Linden 6

D – 10099 Berlin

Francesco Beretta

Head of Digital History Research Team

LARHRA UMR CNRS 5190,

14, Avenue Berthelot

F – 69363 Lyon CEDEX 07

contact: d4h2020@sciencesconf.org