Deniz Kilincoglu und ich haben gerade unser Projekt „Travels in the 19th century Ottoman Empire“ auf der Tagung „On the Way into the Unknown? Comparative Perspectives on the ‚Orient‘ in (Early) Modern Travelogues“ in Wien, die vom 28.-30.11.2019 am Institut für Neuzeit und Zeitgeschichtsforschung der Österreichischen Akademie der Wissenschaften stattfindet, vorgestellt. Hier sind die Folien des zweiten Teil unseres Vortrags, der sich mit den Tools und den Plänen für ein Text Mining Portal für Reiseberichte ins Osmanische Reich im langen 19. Jahrhundert beschäftigt.

Archiv der Kategorie: Digital Library

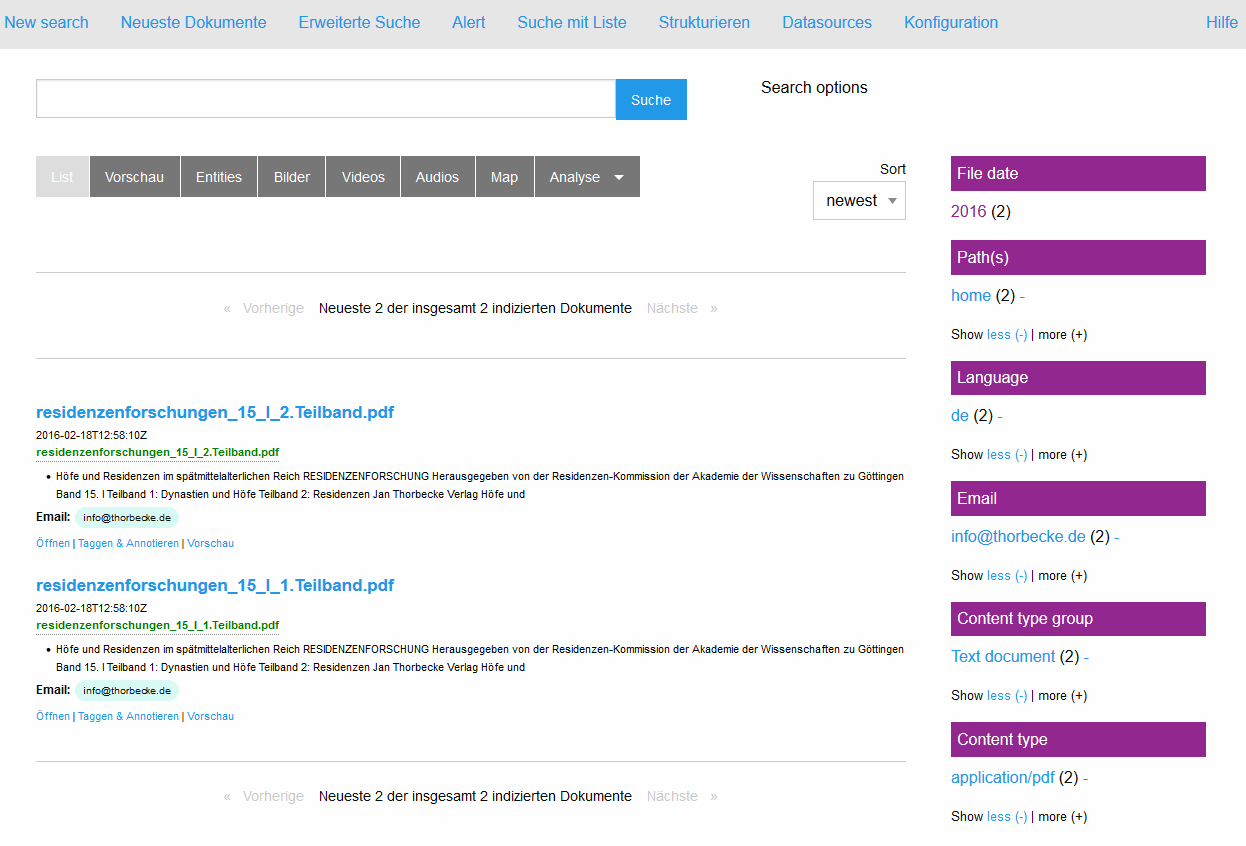

Workshop: Text Mining mit Open Semantic (Desktop) Search – eine digitale Such- und Annotationsumgebung für informationsgetriebene Fragestellungen in den Geisteswissenschaften. DHd 2019, Mainz, 25.3.19.

Am 25.3.19 findet ein Workshop zu Open Semantic (Desktop) Search (OSDS) auf der DHd in Mainz statt. We are so exited :-). Er basiert auf dem Hands On, der auf dem Historikertag 2018 in Münster durchgeführt wurde. Dieser Blogbeitrag leitet durch die Installation von OSDS und stellt Nutzungsbeispiele vor.

Die zugehörigen Slides für den Workshop finden Sie hier.

Zunächst einmal – worum handelt es sich? OSDS ist eine freie Software, die nur aus Open Source Bestandteilen zusammengestellt wurde und auf dieser Grundlage als Donationware weiter entwickelt wird. Das Projekt stammt aus dem Journalismus und spezieller aus dem Bereich des investigativen Journalismus, der sich heutzutage mit teilweise riesigen Datenmengen (Stichwort: Panama Papers) auseinander setzen muß/möchte.

Der Entwickler hinter OSDS ist Markus Mandalka, der den Workshop mit ausrichtet und in den letzten Tagen auch ein neues Release von OSDS vorbereitet hatte. Open Semantic Search kann man auf der oben verlinkten Seite von Markus Mandalka in drei Varianten, die er über die Webseite www.opensemanticssearch.org und ein dazugehöriges github-repository anbietet, herunterladen:

1. Open Semantic Desktop Search

2. Open Semantic Search Appliance

3. Open Semantic Search Server (Package)

Paket 1 ist eine VM Appliance, die man mit Oracle Virtual Box laden und lokal auf einem Rechner betreiben kann. Für den Workshop wurde die VM auf den aktuellen Stand von Virtual Box (6.0.4.) angepaßt. Die Appliance wird in zwei Varianten zum Download angeboten: einmal mit englischen und einmal mit deutschen Keyboard Settings. Die deutsche Version wurde vor kurzem aktualisiert (08.04.19). Die anderen Versionen sind teilweise noch auf dem Stand von Dezember 2018. Für den workshop nutzen wir die aktuelle deutsche Version.

Die zweite Variante ist ebenfalls eine Appliance, die ebenfalls unter Oracle Virtual Box läuft, aber nur einen Server als localhost bereit stellt. Dort fehlt der „Desktop“ im Debian Linux, auf dem beide Distributionen aufsetzen. Wie das so bei virutuellen Maschinen für Virtual Box üblich sind, bringen die Appliances ein gewisses Gewicht auf die Waage. Die OSDS Version schlägt mit etwa 3GB zu Buche, die Servervariante OSS mit (nur) 1.8 GB. Das dritte Paket (OSSS) ist mit etwa 300 MB am Leichtgewichtigsten, aber erwartet natürlich auch eine Installation und vor allem Konfiguration auf einem Debian oder Ubuntu basierten System. Letzteres haben wir inzwischen ausprobiert und es hat auch gut funktioniert: https://teaching.gcdh.de/search/ .

Bevor wir zur mit der Installation von OSDS beginnen, vorab noch einige Informationen zum Leistungsumfang des Pakets und warum es sich überhaupt lohnt, sich damit zu beschäftigen. Kernstück der Enterprise Suchmaschine ist ein Lucene SOLR Indexer (Elastic Search ist ebenfalls verwendbar), mit dem recht beliebige Dokumente indexiert werden können. Die enthaltenen Informationen werden damit als Keyword im Kontext findbar und referenzierbar. Aber OSDS ist noch wesentlich mehr. In dem Paket ist auch ein sogenanntes Open Semantic ETL (Extract-Transform-Load) Framework integriert, in dem die Texte für die Extraktion, Integration, die Analyse und die Anreicherung vorbereitet werden. Es handelt sich um eine Pipeline, die einem sehr viel von Arbeit hinsichtlich der Bereitstellung der Texte für den Indexer abnimmt. Wer mit Lucene/Solr arbeitet weiß, wie viel Zeit die Aufbereitung der Daten in der Regel beansprucht. OSDS nimmt einem viel davon ab und kümmert sich nach dem Prinzip eines überwachten Ordners um sämtliche Schritte, die von der Extraktion über die linguistische Analyse bis zur Anreicherung mit weiteren Metadaten notwendig sind. Schliesslich stellt das Paket auch einen Webservice (Rest-API) für die maschinelle Kommunikation sowie ein durchdachtes User Interface zur Verfügung, mit dem die Suchmaschine bedient, konfiguriert und natürlich auch durchsucht werden kann. Die facettierte Suche spielt dabei eine besondere Rolle, da die Facetten mehr oder weniger automatisch aus der linguistischen Analyse der Texte und auf der Grundlage von (konfigurierbaren) Namen Entities (Personen, Orte, Organisationen etc.) gebildet werden. Entsprechend sind auch die Hauptfunktionen des Softwarepakets angelegt: Sucheninterface, ein Thesaurus für Named Entities, Extraktion von Entitäten in neu zugefügten Texten, eine listenbasierte Suche sowie eine Indexfunktion, die den Aufbau des Suchindex neu anstößt. Und das alles in einem einfach zu bedienden Userinterface, das mit der Maus bedient werden kann.

Wer nun neugierig oder enthusiastisch geworden ist, dem sei gesagt, dass es wie meist im Leben einen Wermutstropfen gibt: insbesondere OSDS aber auch OSS brauchen gewisse Ressourcen, um ihre Arbeit effizient verrichten zu können. Als Mindestausstattung für einen Betrieb unter Orcale Virtual Box gebe ich 8 GB RAM und (der Größe des Projekts entsprechend) ausreichend Speicherplatz auf einer SSD an. Eventuell kann man sich, bei schwacher Hardware, eines Tricks bedienen und den Index auf einer schnellen Maschine (aktueller Mehrkernprozessor mit möglichst üppigem RAM) erstellen lassen und dann beides (Appliance und Solr-Index) auf das betreffende Gerät zurückspielen. Meist reicht dann die Performance, um zumindest die Suchfunktionalität auch auf schwächerer Hardware zu ermöglichen. Ein weiterer Ressourcenfresser beim Anlegen des Index ist OCR. OSDS hat Tesseract als eigene OCR Egine inkl. (hört hört) Frakturerkennung! integriert. Wenn man seine PDF Dokumente aber vor der Indexierung erst noch mit der OCR behandelt, kann man den Rechner bei entsprechender Materialfülle gerne mal ein oder zwei Tage beschäftigen, bevor sich (hoffentlich) ein brauchbares Ergebnis zeigt. Daher rate ich (ebenso wie der Entwickler es tut) dazu, OCR erst mal abzustellen, wenn man es nicht unbedingt braucht (geht im Konfigurationsmenue) und den Index zunächst mal nur mit schon vorhandenen Textlayern oder am besten mit Dokumenten zu füttern, die eh nur aus Text bestehen. Dabei ist die Suchmaschine recht offen für Formate und bringt eine Menge Filter mit, die den Text extrahieren können (hier mal die Liste von der Webseite kopiert: text files, Word and other Microsoft Office documents or OpenOffice documents, Excel or LibreOffice Calc tables, PDF, E-Mail, CSV, doc, images, photos, pictures, JPG, TIFF, videos and many other file formats). Im Hintergrund werkelt hier natürlich Apache Tika.

Gesamte Redaktion verläßt Elsevier, um eigenes Open Access Journal zu gründen

Die ganze Redaktion einer wiss. Zeitschrift (Lingua) hat bei Elsevier gekündigt um gegen die Subscriptionspreise und die Weigerung des Verlags, Open Access zu gehen, zu protestieren. Die Redaktion wird nun geschlossen ein neues Journal namens Glossa gründen und versucht die Autorinnen und Autoren in dieses neue Open Access Journal mitzunehmen. Ich meine, das sollte auch der Redaktion von Digital Scholarship in the Humanities (DSH – früher LLC) zu denken geben, da das Geschäftsmodell von Oxford University Press sich momentan kaum von dem bei Elsevier unterscheidet. Die gesamte Story ist unter https://www.insidehighered.com/news/2015/11/02/editors-and-editorial-board-quit-top-linguistics-journal-protest-subscription-fees nachzulesen. Ausserdem lese ich gerade in Forschung & Lehre 11/15, dass die Niederländischen Universitäten damit drohen, Elsevier komplett zu boykottieren, wenn die Preise nächstes Jahr nicht gesenkt werden. Da sollten Deutschland oder besser gleich die gesamte EU vielleicht auch mitmachen und die tapferen Niederländer unterstützen. Am Ende hätten alle etwas davon (ausser Elsevier), wenn man sich in dieser Frage solidarisch verhält!

„Open access“ von Open Access – Extrahiert aus [1]. Lizenziert unter Gemeinfrei über Wikimedia Commons – https://commons.wikimedia.org/wiki/File:Open_access.svg#/media/File:Open_access.svg

Tagungsbericht „Semantic Web in den Geisteswissenschaften“ / Paris INHA 2014: Outils, méthodes, corpus: la modélisation des données en SHS.

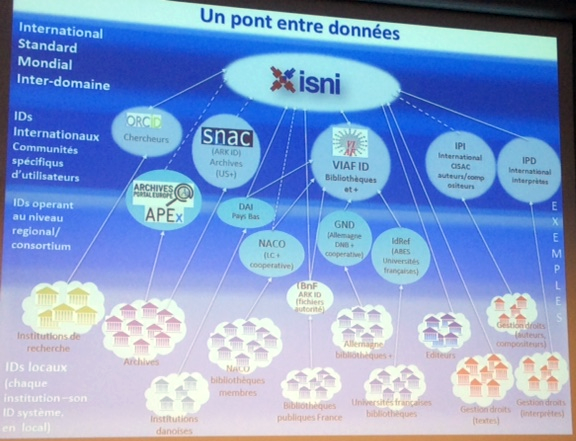

Am 17.11.14 fand in Paris ein Studientag zum Thema „Werkzeuge, Methoden, Korpora: die Modellierung von Daten in den Geistes –und Sozialwissenschaften“ statt. Organisiert und ausgerichtet von Emmanuelle Perrin im INHA, einem Zentrum für die Kunstgeschichte im Zentrum von Paris – sehr schön gelegen in der Nähe der alten BNF (Richelieu) – präsentierten sich 6 Projekte rund um das Thema Semantic Web Technologien (SWT) und Geisteswissenschaften. Dabei ging es nicht nur um kunsthistorische Projekte im engeren Sinne, sondern vielmehr um einen Überblick zu den zentralen Konzepten der digitalen Semantisierung von Daten, also Normdaten, kontrollierte Vokabularien, Ontologien und Linked Open Data (LOD). Eine zentrale Rolle bei der Umsetzung von Projekten mit SWT spielt in Frankreich die BNF und das CNRS. Beide Institutionen waren vertreten zum einen durch Antoine Isaac, dem Leiter der Abteilung Forschung und Entwicklung des Europeana-Projekts und zum anderen durch Didier Torny, dem stellvertretenden Direktor für Wissenschaftliche Information am InSHS, einer Abteilung des CNRS zur Unterstützung von Sozial- und Geisteswissenschaftlern in informationstechnologischen Dingen. Didier Torny stellte seinem sehr allgemein gehaltenen einführenden Beitrag (Données, corpus, publications : les enjeux de l’information scientifique et technique au CNRS à l’ère numérique) die drei wichtigen Organisationen bzw. Projekte bei der Unterstützung der Forscherinnen und Forscher vor: CLEO (Centre de l’edition electronique ouverte), Persée (ein Online-Zeitschriftenarchiv) und HumaNum, das Pariser Zentrum für Digital Humanities. Emmanuelle Perrin von der InVisu Gruppe des INHA, betonte die zentrale Rolle des Semantic Web für die langfristige und vor allem auch interoperable Bereitstellung von Daten und Forschungsergebnissen in den Geisteswissenschaften und stellte das eigene Projekt (STORM), eine Topographie der Stadt Kairo anhand europäischer Quellen, vor. Der Beitrag von Anila Angjeli (BNF) war hauptsächlich dem Thema Normdaten und hier speziell dem ISO Standard ISNI gewidmet, einem Versuch der BNF und der British Library, die verschiedenen nationalen Normdaten zu harmonisieren und zu integrieren. Obwohl der Ansatz sicher sehr zu begrüßen ist und offensichtlich gute Algorithmen für die Elimination von Dubletten und die Zuordnung der versch. Datensätze eingesetzt werden, bleibt doch das alte Problem vieler derartiger Projekte bestehen, dass (projekt-)relevante Personen im Datenbestand (immerhin inzwischen 8 Mio!) fehlen und nicht ohne weiteres beigefügt werden können. Der günstigste Weg ist hier eine Mitgliedschaft im ISNI Verband, der mit 800,- Euro/Jahr zu Buche schlägt.

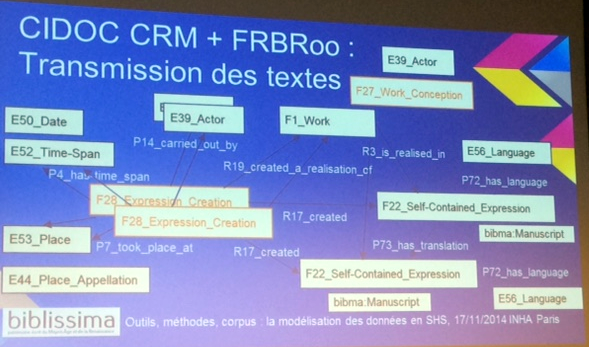

Nach der Pause sprach René-Vincent Du Grandlaunay, der Direktor der Bibliothek des Dominikanerinstituts für Orientstudien in Kairo (IDEO) über das Modell FRBR (Functional Requirements for Bibliographic Records) zur Katalogisierung und seiner Anwendung auf die im Institut kuratierten Publikationen aus dem arabisch-islamischen Kulturkreis. Die detailverliebte Darlegung zeigte, wie hilfreich ein FRBR-Ansatz in einem Kontext sein kann, in dem Einzelausgaben aus vielen Jahrhunderten einem Werk zugeordnet werden müssen. Der letzte Beitrag des Vormittags von Matthieu Bonicel und Stefanie Gehrke war dem Europeana Projekt „Biblissima“ gewidmet, das sich mit der Modellierung der Überlieferungsgeschichte von Texten und Sammlungen im Mittelalter und der Renaissance beschäftigt. Die Modellierung erfolgt dort in CIDOC-CRM und FRBRoo und in der Präsentation konnten schon eine Reihe von interessanten Lösungen für die Modellierung von Sammlungen, aber auch von Inventaren und Katalogen vorgestellt werden.

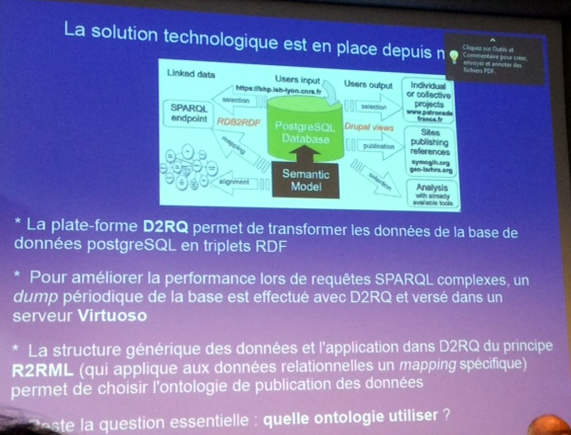

Der Nachmittag war den Themen Linked Open Data (LOD), Ontologien für Historiker und einem Wörterbuchprojekt zum Wandel der Begrifflichkeit in der Kunstgeschichte zwischen 1600 und 1750 an der Universität von Montpellier gewidmet. Anne-Violaine Szabados (CNRS, ArScAn, UMR 7041, ESPRI-LIMC, Paris Ouest Nanterre La Défense) sprach über die Erfahrungen mit den Projekten LIMC und CLAROS, die beide dem Bereich der Archäologie zugeordnet werden können und auf die Vernetzung und Verlinkung mit LOD setzen. Francesco Beretta (CNRS, LARHRA, UMR 5190, Université de Lyon) stellte anhand des Historischen Projekts SyMoGIH (Système Modulaire de Gestion de l’Information Historique) die Probleme von Historikern bei der Suche nach einer passenden Ontologie für historische Ereignisse dar.

Das EU-geförderte Projekt LexArt, das von Flore César (CRISES, EA 4424, université Paul-Valéry, Montpellier 3) präsentiert wurde, steht noch anz am Anfang. Es versucht die Entwicklung von Kunstbegriffen in der Frühen Neuzeit anhand einer detaillierten Analyse von 300 Kunsttraktaten und Abhandlungen nachzuzeichnen, die anhand eines digitalen Werkzeugs gesammelt, analysiert und präsentiert werden sollen. Dies wird in Zusammenarbeit mit dem Trierer Zentrum für Digital Humanities realisiert werden, das entsprechend Expertise im Kontext digitalisierter Wörterbücher besitzt. Zum Abschluss fasste Mercedes Volait (InVisu, USR 3103 CNRS/INHA) die Ergebnisse des Tages noch einmal zusammen und erwähnte dabei auch einige der Themen, die nicht angesprochen werden konnten, wie z.B. die juristischen Fragen rund um LOD.

Insgesamt stellt sich für mich das Interesse an Semantic Web Technologien für geisteswissenschaftliche Projekte in Frankreich positiv da. Darauf weisen zumindest die besprochene Veranstaltung aber auch andere Aktivitäten in diese Richtung hin, die derzeit vor allem in Paris stattfinden. Am 12 Dezember wird dort z.B. eine Schulung „Einführung in das Semantic Web“ durch den früheren Leiter der Informatikabteilung der BNF, Romain Wenz, angeboten. Insbesondere die Ausrichtung von Europeana, die sich mit EDM auf ein graphenbasiertes Datenformat festgelegt hat, befördert die Akzeptanz und auch die Beschäftigung mit Semantik Web Technologien, gerade in den Geistes- und Sozialwissenschaften. Angebote wie data.bnf.fr erhöhen dabei die Sichtbarkeit und machen den konkreten Nutzen von Semantic Web Technologien evident.

Die Folien der Beiträge sind jetzt online unter: http://invisu.inha.fr/lundi-17-novembre-2014-Outils

Jörg Wettlaufer, Göttingen

Outils, méthodes, corpus : la modélisation des données en SHS.

Emmanuelle Perrin (InVisu, USR 3103 CNRS/INHA) : Présentation de la journée.

Didier Torny (directeur adjoint scientifique en charge de l’information scientifique et technique à l’InSHS) : Données, corpus, publications : les enjeux de l’information scientifique et technique au CNRS à l’ère numérique.

Première parti : Présidence de séance : Antoine Isaac (R & D manager, Europeana)

Anila Angjeli (BnF, département de l’information bibliographique et numérique) : ISNI – Les enjeux d’un identifiant international pour les personnes et les organismes.

René-Vincent Du Grandlaunay (directeur de la bibliothèque de l’Institut dominicain d’études orientales, Le Caire) : Le modèle FRBR appliqué au patrimoine arabo-musulman.

Matthieu Bonicel (BnF, coordinateur de Biblissima) et Stefanie Gehrke (coordinatrice métadonnées, Biblissima) : Biblissima et la modélisation de l’histoire de la transmission des textes et de la constitution des collections.

Seconde partie (Présidence de séance : Anila Angjeli)

Anne-Violaine Szabados (CNRS, ArScAn, UMR 7041, ESPRI-LIMC, Paris Ouest Nanterre La Défense) : L’expérience LIMC & CLAROS : pour l’élévation des données du patrimoine et de la culture dans le Linked Open Data.

Francesco Beretta (CNRS, LARHRA, UMR 5190, Université de Lyon) : Le projet SyMoGIH et le web de données.

Flore César (CRISES, EA 4424, université Paul-Valéry, Montpellier 3) : Modéliser le transfert des savoirs en Europe septentrionale aux xviie et xviiie siècles : l’exemple du projet LexArt.

Mercedes Volait (InVisu, USR 3103 CNRS/INHA) :Synthèse de la journée et discussion.

Rückschau: DH2014 Lausanne, Switzerland – 7.7.-11.7.2014

DH2014 ist vorbei und Deutschland Fussball-Weltmeister. Da gibt es zwar keinen direkten Zusammenhang, aber auf der Tagung war auch nicht bei allen Vorträgen der Zusammenhang zu Digital Humanities offensichtlich, daher sei diese Bemerkung hier einmal erlaubt. Mit den Workshops am Montag und Dienstag dauerte die Tagung eine ganze Woche, die prall gefüllt war mit Vorträgen, Postern, einem Fun Run und sehr sehr viel Regen. Das Wetter hat sicher auch so manchen davon abgehalten, die reizvolle Landschaft des Genfer Sees näher zu erkunden. Statt dessen drängte es sich am Veranstaltungsort. Mit über 700 Teilnehmerinnen und Teilnehmern war DH2014 bislang die größte Veranstaltung ihrer Art. Das hat sich natürlich auch auf den Charakter der Konferenz ausgewirkt.

Am ersten Tag der Tagung war es schwierig, eine der acht Parallelsektionen zu besuchen, so voll waren die darfür vorgesehenen Räume. Das ist aber vielleicht auch schon der einzige Kriktikpunkt, den man der ansonsten vorbildlich von Claire Clivaz (UNIL) und Frederik Kaplan (EPFL) organisierten Tagung anheften kann. Besonders hervorzuheben ist die Vorbereitung der Tagung durch Melissa Terras (UCL), die das peer review der Beiträge organisierte und sich auch sonst als gute Seele der Konferenz herausstellte (sozusagen der Schweinsteiger der DH). Für die verhinderte Bethany Nowviskie (University of Virginia Library) sprach sie deren Redemanuskript – digital humanities in the anthropocene – eine teilweise düstere und zugleich poetische und feinfühlige Reflektion über DH im Kontext von Umwelt, Natur und Technologie der modernen Welt. Die Frage nach der Relevanz des von ihr konstatierten Artensterbens für die Arbeit in den DH blieb über die postulierte Analogie von Vergänglichkeit in Natur und Kultur hinaus für mich zwar weitgehend unbeantwortet, aber ein Ohrenschmaus war die Rede allemal für diejenigen, die der englischen Sprache auf dieser Schöpfungshöhe mächtig sind (bei einer internationalen Tagung wie dieser übrigens nicht unbedingt ein Zustand, von dem man ausgehen sollte). Sie brachte auch etwas politisches in die DH Community, das ich bislang so nicht wahrgenommen hatte.

A propos Community. Ray Siemens beschwor diese Community in gewohnt souverainer Art in seiner Keynote: Das wir zählt! Alle, die sich noch irgendwie nicht zur großen Gemeinschaft der Digital Humanities zugehörig fühlten – spätestens nach seiner Rede waren sie in den weiten rhetorischen Armen von Siemens angekommen. Das führte aber sogleich zu Lästerei auf Twitter, diesem vermutlich von der NSA ins Leben gerufenen Kurznachrichtendienst, bei dem man der gesamten Welt in Echtzeit mitteilen kann, was man gerade denkt, fühlt und macht. Die Kritik prallte aber an Siemens ab wie der Zölibat am Papst (siehe aber, inzwischen dementiert: Katholische Priester: Papst Franziskus deutet Lösungen in Zölibatsfrage an). Und das ist auch richtig so, denn wir haben ja schließlich gestern erst gesehen, dass Teamgeist und „Community“ alles erreichen kann, wenn er bzw. sie nur wollen – sogar den Weltmeistertitel.

Sehr gelungen waren auch das Logo und die Corporate Identity der Tagung. Die von einem „italienschen“! Designer entworfenen Netzwerkvisualisierungen der aktiven Tagungsteilnehmerinnen und -teilnehmer, die zunächst als begehbare Bodenkunst vor dem (imposanten und gerade neu eröffneten) Swiss Tech Convention Centre sowie auch multimedial (mit Photos)! gezeigt wurden, kamen sehr gut an und waren ein guter Icebreaker für die Kontaktaufnahme. Diese kleinen Kunstwerke waren damit vielleicht dem Kern von „Digital Humanities“ näher als einige der Vorträge an den folgenden Tagen.

Fast hätte ich nun bei meiner kurzen Umschau die Eröffnungsvorlesung von Bruno Latour, dem großen französischen Wissenschaftshistoriker, vergessen. Er sprach zum Thema: „Rematerializing Humanities Thanks to Digital Traces“. Seiner Beobachtung des Wiederstarken des „Empirismus“ durch die moderne Digitalisierung ist inhaltlich und faktisch zuzustimmen. Es bleibt für mich allerdings offen, ob das „Digitale“ wirklich am treffendsten durch seine Materialität beschrieben ist – als ob Denkprozesse im Gehirn weniger materiell wären? Aber das sind vielleicht philosophische Fragen, mit denen sich die Geisteswissenschaftler beschäftigen sollten. Ich als Digitaler Humanist bin jedenfalls auch gerne materiell…

Zum Schluß noch einige Links zu interessanten Projekten oder Folien, die mir im Laufe der Tage unter gekommen sind. Die nächste DH Konferenz der ADHO findet übrigens vom 29. Juni bis 3. Juli 2015 in Sidney statt! Und 2016 folgt dann Krakau.

Tagungswebseite

Deutsches Kulturerbe auf dem Weg in die Europeana II

Konferenz am 20. und 21. März 2014 in der Staatsbibliothek zu Berlin

„Die Konferenz deckt eine große Bandbreite der rund

um die Europeana diskutierten und bearbeiteten Themen ab. Dabei stehen

inhaltliche, technische sowie vermittlungsbezogene Fragestellungen und

Metadaten-Standards im Mittelpunkt. Schließlich zeigen stark inhaltlich

orientierte Europeana-Projekte die Vielfalt des digitalen Kulturerbes

Europas, von Materialien zum Ersten Weltkrieg über antike Inschriften

bis hin zu Kreationen von Mode-Designern.Veranstalter

der Tagung sind AthenaPlus, Deutsche Digitale Bibliothek, Europeana

Collections 1914-1918, European Film Gateway, Europeana Inside, Partage

Plus und die Stiftung Preußischer Kulturbesitz.“

Lightning Talk auf der SWIB 2012 in Köln

Bild

Eine kurze Präsentation unseres Forschungsverbundes, für den ich zur Zeit arbeite…

Tagungsbericht SWIB 2012 / #swib12

Die diesjährige SWIB (Semantic Web in Bibliotheken), veranstaltet vom HBZ NRW zusammen mit der ZBW in Hamburg und Kiel, fand in Köln vom vom 26. Bis 28. November 2012 statt. Diese seit 2009 bestehende Inititative der beiden Ausrichter hat sich seit der Gründung zu einer inzwischen internationalen Tagung mit ca. 170 Teilnehmerinnen und Teilnehmern aus 23 Ländern entwickelt. Die Tagungssprach war erstmals durchgehend Englisch. Den Auftakt machten am 26.11. drei halbtägige workshops, die zu den Themen Einführung in LOD, Metadata Provenance und Doktoranden mit LOD Projekten veranstaltet wurden. Gerade im Doktorandenworkshop erhofft sich die Tagungsorganisation einen intensiveren Austausch mit der aktuellen Forschung rund um Semantic Web und Linked Open Data. Der diesjährige Fokus der Tagung lag auf konkreten Anwendung von Semantic Web Technologien in Bibliotheken und den Wissenschaften. Die eingeladenen Keynote-Speaker, Jon Voss von LODLAM und Emmanuelle Bermès vom Centre Pompidu in Paris, stellten aus ihrer jeweiligen Perspektive die hauptsächlichen Anwendungsszenarien und Herausforderungen für LOD in Bibliotheken dar und betonten die Notwendigkeit einer Globalisierung der Bibliotheksdienstleistungen im Zuge einer offenen Lizenzierung der Bibliotheksdaten. Dem entsprechend war der zweite Tag der Konferenz auch insgesamt dieser Thematik gewidmet: „Towards an international LOD library ecology“. Mit Beiträgen aus den Niederlanden, Spanien, Deutschland, den USA (via Skype) sowie Frankreich und Norwegen schon am ersten Tag war in der Tat ein Blick auf die internationale Entwicklung und den Stand der Bemühungen der einzelnen Nationabibliotheken möglich. Besonders bemerkenswert für mich waren die Beiträge von Daniel Kinzler zu Wikidata, dem Projekt der Wikipedia Foundation zur Einrichtung einer gemeinsamen Wissensbasis für das in den Infoboxen der Wikipedia-Artikel gesammelte Faktenwissen sowie die von Romain Wenz präsentierte Linked Open Library in der Praxis: das Portal data.bnf.fr, in dem aus den reichen Metadaten der BNF in Paris Informationen zu 20.000 Autoren und ihren Werken zusammengeführt und eine Integration von Daten unterschiedlichster Herkunft ermöglicht wird. Eher ernüchternd klangen dagegen die Erfahrungen aus der HBZ selber, die von Pascal Christoph vom hbz zum Thema „Building a High Performance Environment for RDF Publishing“ am Ende des ersten Konferenztages präsentiert wurden. Bei großen Datenmengen ist im LOD Bereich weiterhin mit Performanceproblemen zu rechnen. Eine vernünftige Volltextsuche wir beim hbz momentan nicht über SPARQL sondern nur externe Indexdienste (in diesem Fall elasticsearch) realsiert.

Sehr positiv aufgefallen ist mir auch dieses Jahr wieder die perfekte Organisation der Tagung. Zum ersten Mal kam dieses Jahr das conftool zum Einsatz, mit dem die Anmeldung sehr angenehm funktionierte. Während der Tagung wurde ein Live-Stream der Beiträge zur Verfügung gestellt. Diese sind nun unter der Adresse: http://www.scivee.tv/browse?brfl=swib12 jederzeit abrufbar. Die Folien zum Einführungsworkshop findet man unter dieser Adresse und auf der Tagungsseite http://swib.org/swib12/ befindet sich das Programm sowie weitere Informationen. Nächstes Jahr geht es wieder nach Hamburg und es ich bin schon gespannt, wie sich diese Veranstaltung in den kommenden Jahren weiterentwickeln wird.

Emtacl registration open / Trondheim October 1-3

Some interesting semantic web talk abstracts at http://emtacl.com/submitted-abstracts/#KimT

Digital Humanities Café at Havard University

Kurzmitteilung

Ein Digital Humanities Café als Teil der Harvard LibGuides https://guides.library.harvard.edu/digitalhumanities