For more information see: http://SW4CH2015.ensma.fr/

——————————————————————————————-

IMPORTANT DATES

* Paper submission: April 24, 2015

* Paper notification: June 1, 2015

* Camera-ready paper: June 13, 2015

* Workshop: September 8, 2015

OVERVIEW

Nowadays, Cultural Heritage is gaining a lot of attention from academic and industry perspectives. Scientific researchers, organizations, associations, schools are looking for relevant technologies for accessing, integrating, sharing, annotating, visualizing, analyzing the mine of cultural collections by considering profiles and preferences of end users.

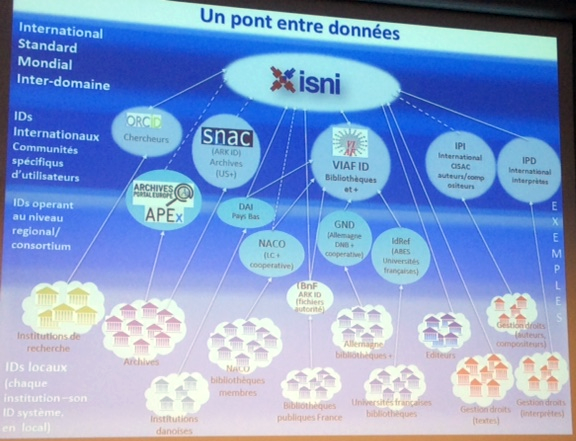

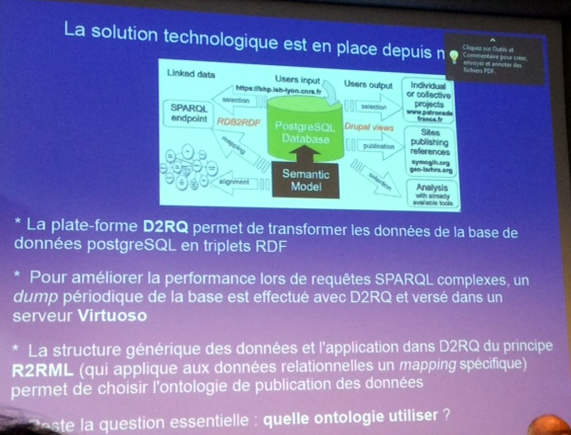

Most cultural information systems today process data based on the syntactic level without leveraging the rich semantic structures underlying the content. Moreover, they use multiple thesauri, or databases, without a formal connection between them. This situation has been identified in the 90’s when the need to build a unique interface to access huge collection of data has appeared. During the last decades, Semantic Web solutions have been proposed to explicit the semantic of data sources and make their content machine understandable and interoperable. By analyzing the most important conferences and workshops related to the Semantic Web, four main categories of topics have been identified: (i) the development of Ontologies and vocabularies dedicated to the studied domain, (ii) explicitation of collection semantics, (iii) usage of Semantic Web Cultural Heritage and (iv) applications related to Cultural Heritage.

The aim of our SW4CH Workshop is to bring together Computer Scientists, and more precisely Data Scientists, involved in Semantic Web solutions for Cultural Heritage. The goal is to exchange experiences, build a state of the art of realizations and challenges and reuse and adapt solutions that have been proposed in other domains.

RESEARCH TRACKS

We seek original and high quality submissions related to one or more of the following topics:

Development of Ontologies and Vocabularies

• User Requirements life cycle for Cultural Heritage

• Vocabularies, metadata schemas, and ontologies

• Semantic Web content creation, annotation, and extraction

• Ontology creation, extraction, and evolution

• Ontology mapping, merging, and alignment

• Use and development of standards, such as SKOS, VRA, etc.

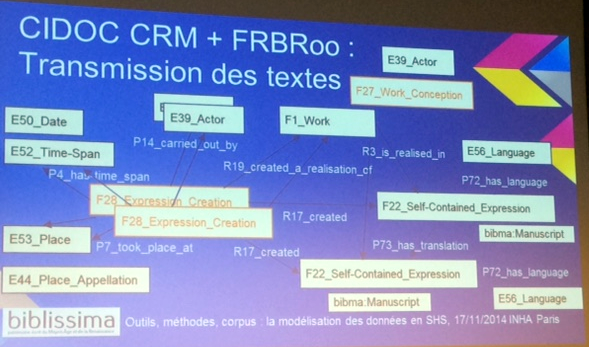

• Developments and applications of the CIDOC Conceptual Reference Model (CRM)

• Virtual Cultural Heritage collections

• Integration of virtual and physical collections

• Use of common vocabularies for Cultural Heritage

• Ontology design patterns for Cultural Heritage

Explicitation of Semantics of Cultural Heritage

• Search, query, and visualization of the Cultural Heritage on the Semantic Web

• Search of virtual and integrated Cultural Heritage collections

• Personalized access of Cultural Heritage collections

• Contex-aware information presentation

• Navigation and browsing

• Facet browsers

• Interactive user interfaces

• Social aspects in Cultural Heritage access and presentation

• Trust and provenance issues in mixed collection and mixed vocabulary applications

Usage of Semantic Web

• Creative industries

• Municipality public services

• Tourist services

• Museums

• Digital Libraries

• Integration of virtual and physical collections

• Ambient Cultural Heritage

• Mobile museum guides

• Web-based museum guides

Applications of Semantic Web technologies in Cultural Heritage

• Domain ontologies

• User and context ontologies

• Reasoning strategies (e.g. context, temporal, spatial)

• Robust and scalable knowledge management and reasoning on the Web

• Machine learning and NLP techniques

• Applications with clear lessons learned

• Semantic Web technologies for multimedia content

• Cultural Heritage services

• Semantic Web architectures for Cultural Heritage

• Peer-to-peer Cultural Heritage architectures

• Data and Information Systems Integration and Interoperability

SUBMISSION INFORMATION

Authors are invited to submit unpublished original work. Submitted papers must use the LNCS style http://www.springer.com/series/11156 (see the link „Instructions for Authors“ in the right hand side) and may not exceed 10 pages. Papers will be submitted electronically in PDF, using this link: http://www.easychair.org/conferences/?conf=sw4ch2015.

ORGANIZATION

Program Co-Chairs: Béatrice Bouchou Markhoff, LI, Université François Rabelais de Tours, France, and Stéphane Jean, LIAS/ENSMA, France

Other members of the organization, including the Program Committee, can be found at: http://SW4CH2015.ensma.fr/

*** Proceedings to be published by Springer in the Advances in Intelligent Systems and Computing series (http://www.springer.com/series/11156) *** *** Best papers to be published in a special issue of Information System Frontiers, Springer (Factor Impact = 0.761) ***

—

Béatrice Bouchou Markhoff

Maître de conférences HDR

LI & UFR Sciences et Techniques

Université François Rabelais Tours, France

Tél. +33 (0) 2 54 55 21 36

http://www.info.univ-tours.fr/~bouchou/