https://pcp-on-web.htwk-leipzig.de/project/page.php?goto=RODBH2019#en

https://pcp-on-web.htwk-leipzig.de/project/page.php?goto=RODBH2019#en

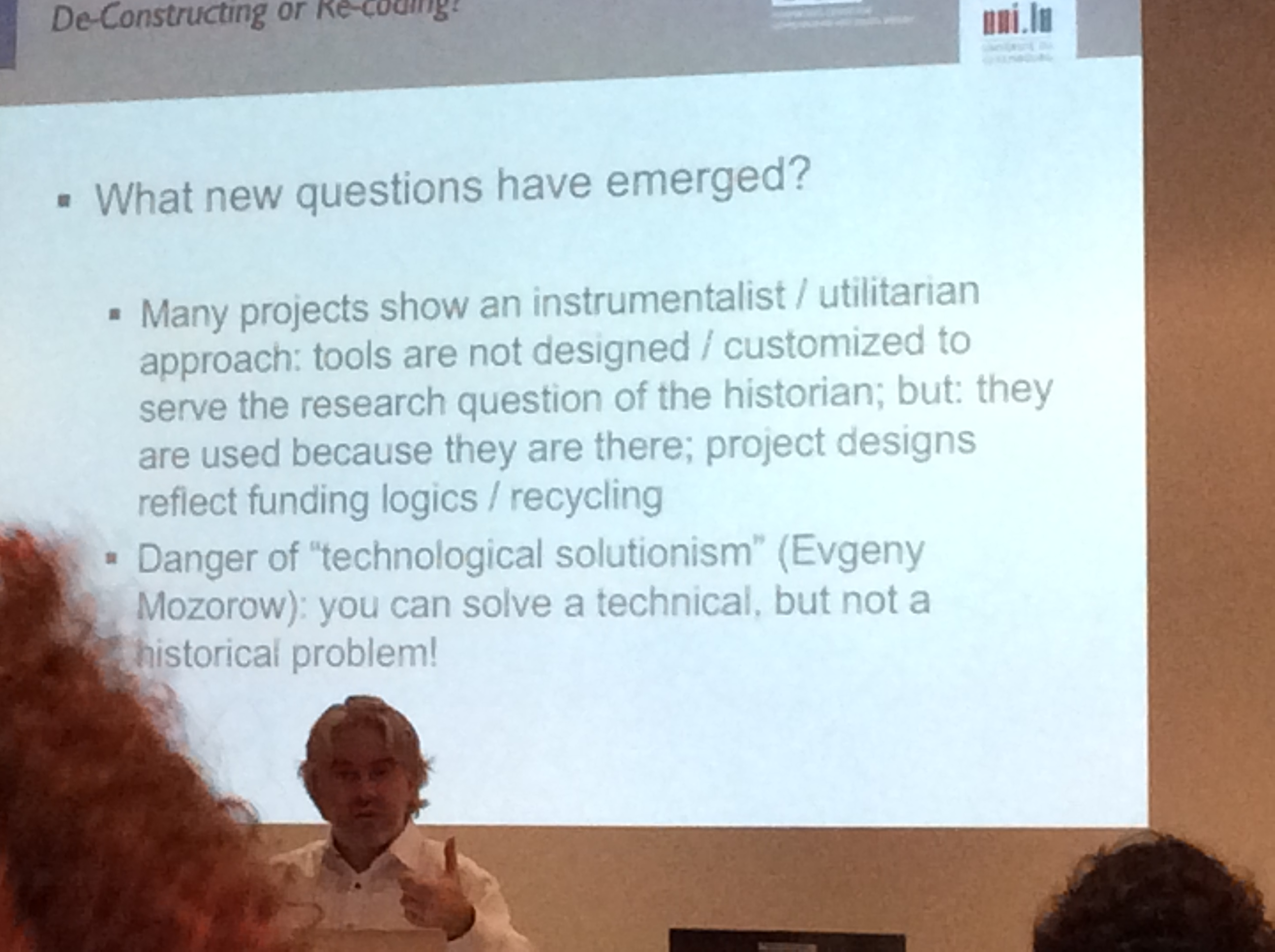

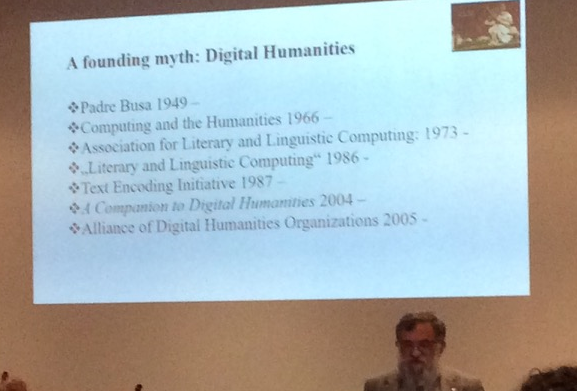

The doctoral symposium deals with research on online databases in the academic field of history. It gathers Ph.D. students from the Humanities, Computer Science and Digital Humanities who are using Semantic Web technologies and are concerned with Ontology building in their projects. The Doctoral Symposium will provide students with:

– a scientific environment within an interdisciplinary and international forum to present their research;

– a discussion platform concerning research and methodologies; and further issues

– an overview of the breadth and depth of Data for History;

– feedback and suggestions from peers and experienced faculty;

– the opportunity to obtain insight into directions for research on online databases in History taken by other doctoral candidates;

– an opportunity to network with peers and future colleagues

The doctoral symposium is hosted by the Leipzig University of Applied Science, Faculty of Informatics and Media (HTWK) as part of the research project “Early Modern Professorial Career Patterns – Methodological research on online databases of academic history”[1], in cooperation with the European Consortium on “Data for History”[2]. A general meeting of the DfH Consortium is part of the workshop and includes the application of “OntoMe – Ontology Management Environment”[3], a platform to design vocabularies using ontologies contributed by the participating Ph.D. students.

Submission, Eligibility and Review Criteria

The paper submission to the doctoral symposium is open only to Doctoral or Ph.D. Students. Accepted papers for the Doctoral Symposium must be presented by the student, for which accommodation and participation are funded by the German Science Foundation (DFG). Travel expenses are reimbursed pro rata.

Submissions will be judged mainly on relevance, originality, technical quality and clarity. Papers must be written in English and be between 4 and 8 pages in length, following the LNI (“Lecture Notes in Informatics”[4]) templates in Word or LaTeX provided by the Gesellschaft für Informatik e.V. . It is planned to publish the peer-reviewed papers.

The contributions may include a vocabulary of the applied research vocabulary under Creative Commons Attribution 4.0 International Public License („Public License“), if available in RDF format. All papers should be submitted using “EasyChair”[5].

Important Dates

- Paper Submission Deadline: February 15, 2019

- Notification of acceptance: March 1st, 2019

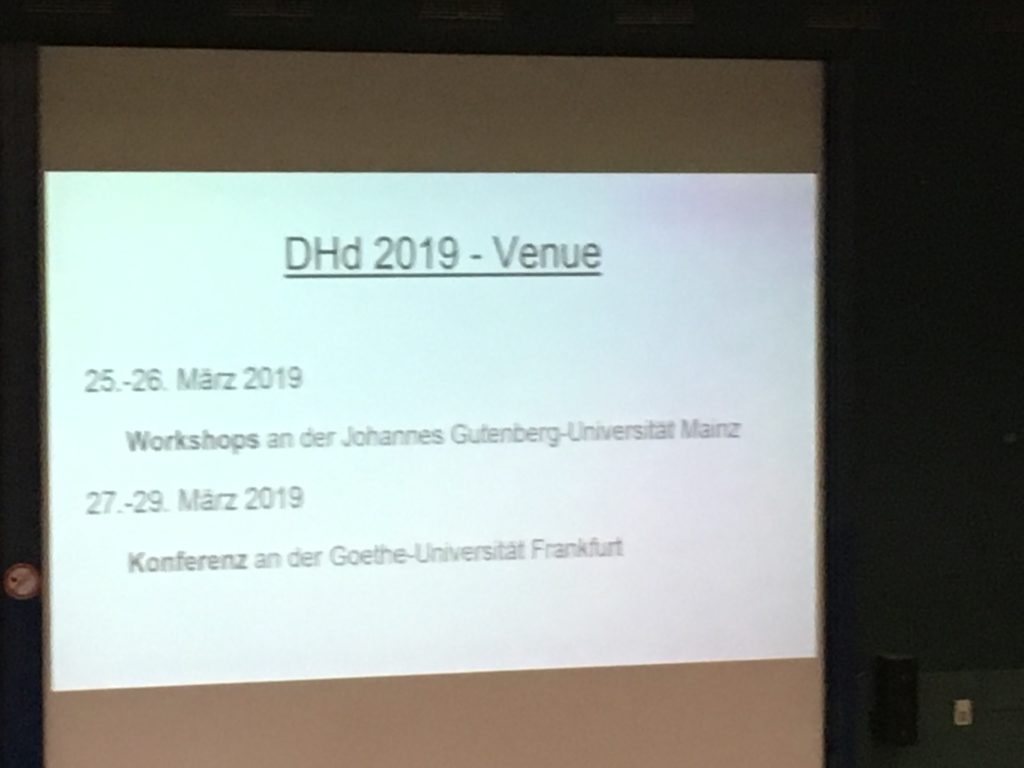

- Doctoral Symposium: April 4th to April 5th, 2019

PC-Chair

- Thomas Riechert (Leipzig University of Applied Sciences, Germany, thomas.riechert@htwk-leipzig.de)

- Francesco Beretta (CNRS, Le Laboratoire de Recherche Historique Rhône-Alpes, France)

- George Bruseker (Foundation for Research and Technology – Hellas, Institute of Computer Science, CCI, Greece)

Organizing Committee

- Edgard Marx (Leipzig University of Applied Sciences, Germany, edgard.marx@htwk-leipzig.de)

- Jennifer Blanke (Herzog-August Library, Wolfenbüttel, Germany, blanke@hab.de)

- Vincent Alamercery (École normale supérieure de Lyon, France, vincent.alamercery@ens-lyon.fr)

[2] http://dataforhistory.org/

[3] http://ontologies.dataforhistory.org/

[4] https://gi.de/service/publikationen/lni/

[5] https://easychair.org/cfp/RODBH2019